インテルの新しい内蔵 AI アクセラレーション・エンジンを活用

AI PC Garden コア技術 AI PC 開発 ドキュメントとトレーニング ヘルプ

DL や AI を加速するテクノロジー

インテル® DL ブースト (int8) |

どのように動作するか

|

すべてのプロセッサーに内蔵された AI アクセラレーション

インテル® Core™ Ultra プロセッサー・ファミリー

インテル® Core™ Ultra プロセッサー・ファミリー

|

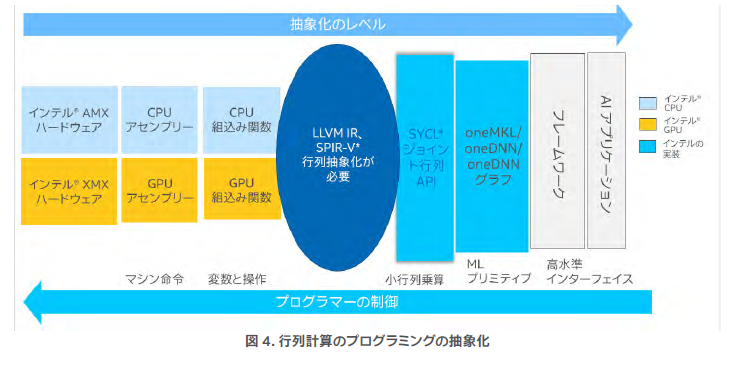

インテル® AMX とインテル® XMX を使用したプログラミング

|

インテル® AI PC Garden ~ AI が未来を創る~インテルは、AI PC を先導する新しいコミュニティー「インテル® AI PC Garden」を開設します。

|

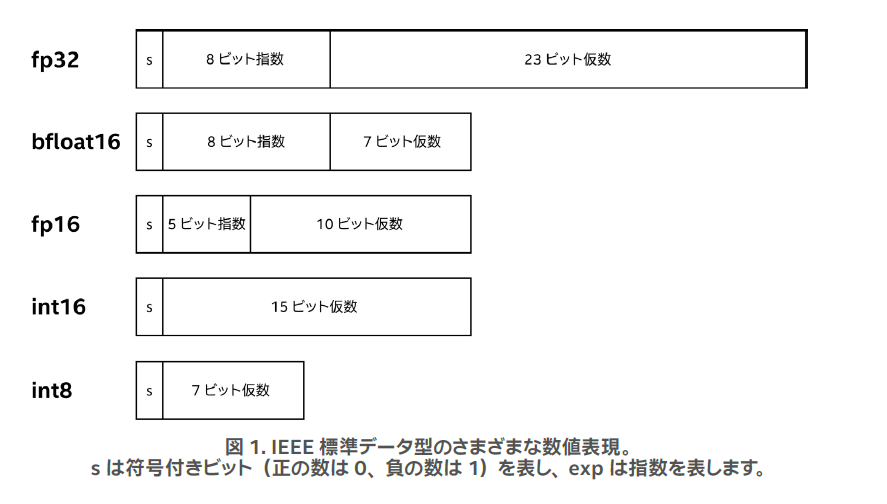

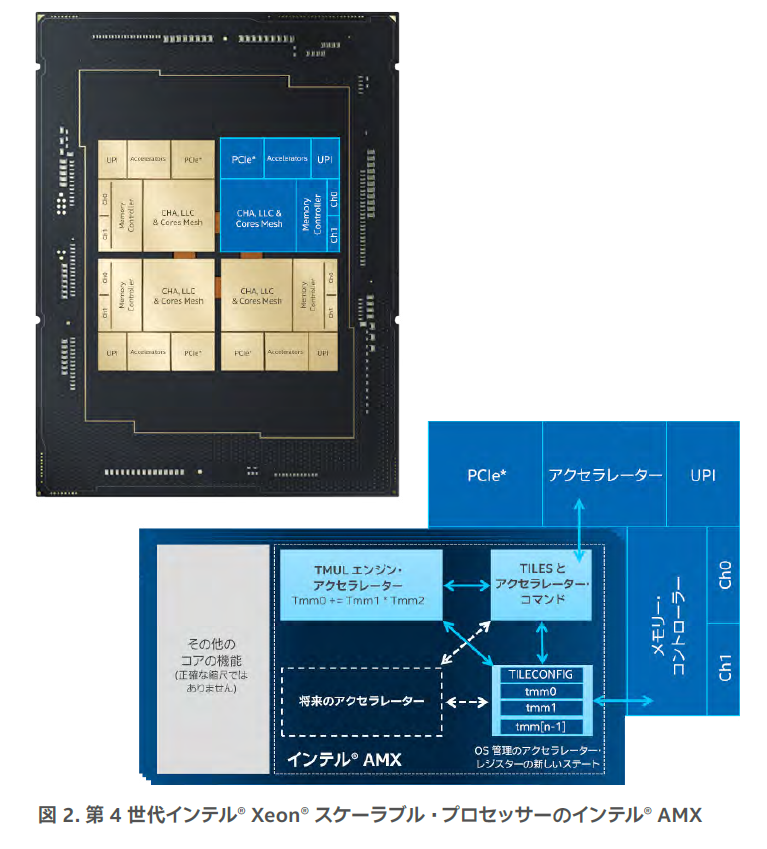

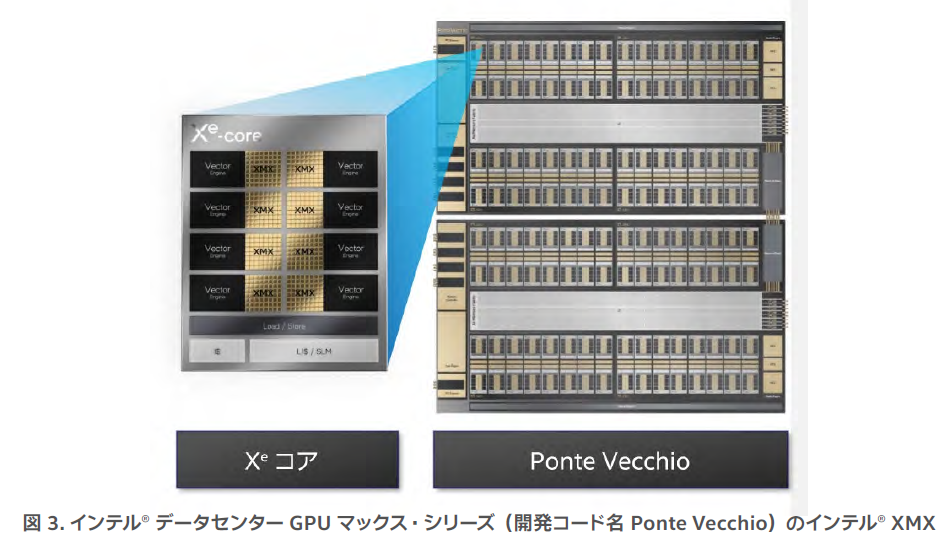

インテル® AMX とインテル® XMXインテル® AMX は、専用のハードウェア・サポートを提供することにより行列演算を高速化します。このテクノロジーは、ディープラーニング推論など、行列計算に大きく依存するアプリケーションに特に有益です。インテル® AMX は、第 4 世代インテル® Xeon® プロセッサーで最初に導入され、新しい第 5 世代インテル® Xeon® プロセッサーでさらに高速化されました。インテル® AMX の詳細は、こちらを参照してください。 人工知能 (AI) が注目されるとともに、パフォーマンスを向上させる方法として、低精度データ型の導入と、これらのデータ型のハードウェア・サポートが求められています。低精度モデルは計算が速く、メモリー・フットプリントが小さくなります。 この理由により、AI トレーニングと 32 ビット以上のデータ型の推論には低精度のデータ型が推奨されます。これらの低精度データ型を最適化およびサポートするには、ハードウェアに特別な機能と命令が必要です。 |

AI PC 開発: すべてのプロセッサーにおける AI アクセラレーションAI を中心としたハードウェアとソフトウェアの進歩により、PC 上で AI 処理が可能になりました。PC での初期の AI 開発からクラウドベースのトレーニング、エッジへの展開までプロジェクトをシームレスに移行できます。AI ワークロードには何が必要であるか、そしてすぐに開始できるものは何かを学びましょう。

インテル® Core™ Ultra プロセッサーは、3D パフォーマンスによるハイブリッド・アーキテクチャーを介して CPU、GPU、NPU を高帯域幅のメモリーとキャッシュを組み合わせることで、PC 上の AI を高速化します。 |

|

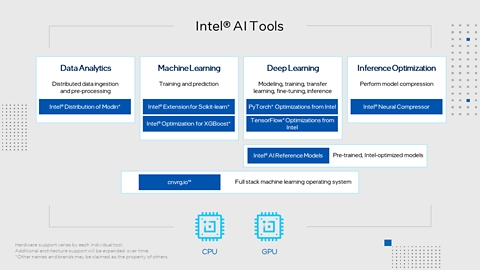

インテルが提供する AI ツールヘテロジニアス処理エンジンを効率良く実行するには、ソフトウェアがハードウェア・アーキテクチャーと命令セットを利用する必要があります。インテルの AI ツールは、TensorFlow*、PyTorch*、scikit-learn*、XGBoost、Modin* などの AI ツールとフレームワークの最適化されたバージョンを提供します。 これらは、CPU、GPU、または両方を最適化する oneAPI ライブラリーを利用しています。これにより、既存のコードとフレームワークを利用して PC 上で AI を開発し、クラウドにシームレスに移行できます。 |

|

OpenVINO™ ツールキットこのツールキットは、ハードウェアのカスタム化オプションと複数のオペレーティング・システムのサポートを必要とする開発者向けのツールです。 ハイパフォーマンス・コンピューター・ビジョンとビジョン・アプリケーションのディープラーニング推論の開発を加速します。インテルの CPU、GPU、NPU 全体で柔軟性のある AI モデルの展開を可能にします。このディストリビューションには、効率良くデプロイするためにモデルを最適化するツールと、モデルを提供するハイパフォーマンス・システムが含まれています。 |

|

PC 上で AI を開発して展開インテルは Microsoft 社と協力して、インテル® プロセッサー向けの AI PC ツールとフレームワークを高速化します。ONNX Runtime*、DirectML、およびオープンソースの Olive モデル最適化ツールを使用して開発および展開します。これらはすべてインテルの CPU および GPU 用に最適化されています。

|

|

AI コースと認定インテルは、開発者、データ科学者、学生、教師向けにトレーニングとリソースを提供しています。個人のペースで勧めることができるコースを受講したり、ライブ・ワークショップに参加したり、一般的な AI からディープラーニングや推論までのトピックに関連するウェビナーを視聴することもできます。 さらに詳しく |

AI PC アクセラレーション・プログラムAI PC アクセラレーション・プログラムは、独立系ハードウェア・ベンダー (IHV) と独立系ソフトウェア・ベンダー (ISV) を、AI ツールチェーン、トレーニング、共同開発、ソフトウェア最適化、ハードウェア、設計リソース、技術的専門知識、共同マーケティング、販売など、インテルのリソースと結びつけます。 さらに詳しく |

AI とマシンラーニング向けツールとリソースインテルの AI ソフトウェアおよびハードウェア製品を詳しく理解し、エコシステムの製品を探してください。最新のブログの投稿やイベント情報を入手し、コミュニティー・フォーラムのサポートを得てください。 さらに詳しく |

AI リソースキット業界およびアプリケーション固有のオープンソース AI リファレンス・キットを使用して、プロジェクトを迅速に開始できます。インテルがデータ科学者や開発者に提供する AI アプリケーション・ツールを基に構築されたダウンロード可能な AI リファレンス・キットは、デジタル革新の推進に役立ちます。 さらに詳しく |

ドキュメントAI PC 開発に役立つ日本語ドキュメントを紹介します。 |

トレーニング |

ヘルプ (フォーラム) |

コードに関連するすべての情報を常に把握サインアップすると、CPU、GPU、FPGA、およびその他のアクセラレーター (スタンドアロンや任意の組み合わせ) に最適化され、優れたコードを作成するのに役立つ最新のトレンド、チュートリアル、ツール、トレーニングなどを受けることができます。 |

インテル® AI PC Garden の Discord はこちら

インテル® AI PC Garden の Discord はこちら