この記事は、Intel AI Blog で公開されている「Unlocking Intel’s Neural Processing Unit with DirectML」の日本語参考訳です。原文は更新される可能性があります。原文と翻訳文の内容が異なる場合は原文を優先してください。

人工知能 (AI) があらゆるアプリケーションで使用されるにつれ、PC エクスペリエンスが変化し、クリエイターが革新できる新しい AI 機能、生産性を高めるツール、そして革新的なコラボレーションが可能になります。この新たな AI エクスペリエンスを実現するには、PC を構築するための新しいアプローチが必要です。インテルは、インテル® Core™ Ultra プロセッサーによって PC における AI の可能性を解放し、次世代の PC エコシステムを立ち上げる AI PC アクセラレーション・プログラムを開始することで PC の変革をリードしています。

インテル® Core™ Ultra プロセッサーの最も注目すべき機能の 1 つは、AI 専用のアクセラレーターであるインテル® ニューラル・プロセシング・ユニット (NPU) が統合されていることです。このアクセラレーターは SoC に直接統合されており、比較的低電力でハイパフォーマンス AI コンピューティングを実行できるため、CPU と GPU から計算リソースを解放できます。この革新は新たな可能性を解放し、PC 上で AI を利用できるようにします。

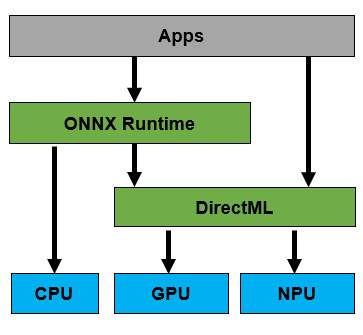

この強力な NPU により PC エコシステムで AI を利用できるようにするため、インテルは Microsoft 社と提携し DirectML により Windows* API をサポートする業界初の NPU となりました。この提携により、開発者は ONNX* Model Zoo モデル、インテル® ニューラル・コンプレッサーなどのツール、そして ONNX* ランタイムを含む豊富な ONNX* (オープン・ニューラル・ネットワーク・エクスチェンジ) のエコシステムを利用して、AI を PC 上で展開できるようになります。DirectML によって NPU がサポートされるため、開発者は次の図のように ONNX* ランタイム API を呼び出すことで、DirectML を介してインテルの NPU に AI モデルをオフロードして実行できます。

これは AI PC の始まりにすぎません。インテル® Core™ Ultra プロセッサー、高い計算能力/低消費 AI エンジン向けの NPU 機能、および 2024年始めに予定されている NPU アクセラレーションをサポートする DirectML のリリースに関する今後の発表に期待してください。私たちは、AI 時代に注目しており、Microsoft 社のパートナーと協力して AI PC を加速し、Windows* 開発エコシステム上でハイパフォーマンスかつ低消費電力の AI を実現し、インテルの開発者がユーザーに革新的な AI エクスペリエンスを提供できるようになることを楽しみにしています。

関連情報: DirectML: Accelerating AI on Windows, now with NPUs (DirectML: NPU により Windows* 上で AI を加速) (英語)