person-detection-action-recognition-0006#

ユースケースと概要説明#

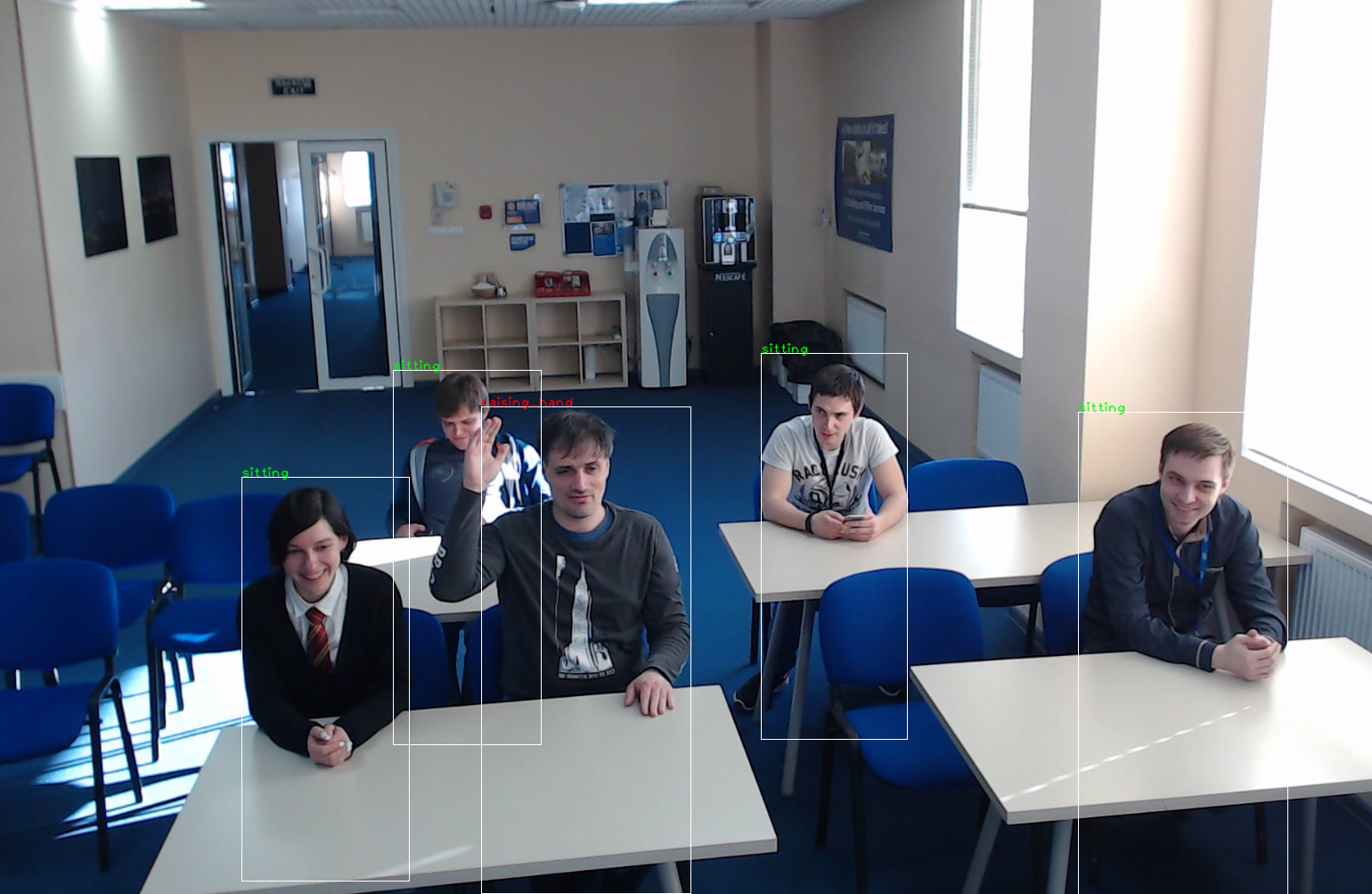

これは、スマート・クラスルーム・シナリオのアクション検出器です。これは、3x3 畳み込みブロックの計算量を削減する深さ方向の畳み込みを含む RMNet バックボーンに基づいています。1/8 と 1/16 スケールの特徴マップからの最初の SSD ヘッドには、4 つのクラスター化された事前ボックスがあり、検出された人物 (2 クラス検出器) を出力します。2 番目の SSD ベースのヘッドは、検出された人物の行動を予測します。考えられる行動: 座る、書く、手を上げる、立つ、振り向く、机の上に横になる

例#

仕様#

メトリック |

値 |

|---|---|

Detector AP (内部テストセット 2) |

90.70% |

精度 (内部テストセット 2) |

80.74% |

ポーズカバレッジ |

座る、書く、手を上げる、立つ |

振り向く、机の上に横になる |

|

隠れた歩行者のサポート |

はい |

オクルージョン・カバレッジ |

<50% |

歩行者の最低身長 |

80 ピクセル (1080p) |

GFlops |

8.225 |

MParams |

2.001 |

ソース・フレームワーク |

TensorFlow* |

平均精度 (AP) は、精度/再現率曲線の下の領域として定義されます。

入力#

画像、名前: input、形状: 1, 400, 680, 3、形式: B, H, W, C、ここで:

B- バッチサイズH- 画像の髙さW- 画像の幅C- チャネル数

予想される色の順序は BGR です。

出力#

最終出力は 4 つのブランチです:

名前:

ActionNet/out_detection_loc、形状:b, num_priors, 4- SSD 形式のボックス座標。名前:

ActionNet/out_detection_conf、形状:b, num_priors, 2- 検出の信頼度名前:

ActionNet/action_heads/out_head_1_anchor_1、形状:b, 50, 85, 6- アクションの信頼度名前:

ActionNet/action_heads/out_head_2_anchor_1、形状:b, 25, 43, 6- アクションの信頼度名前:

ActionNet/action_heads/out_head_2_anchor_2、形状:b, 25, 43, 6- アクションの信頼度名前:

ActionNet/action_heads/out_head_2_anchor_3、形状:b, 25, 43, 6- アクションの信頼度名前:

ActionNet/action_heads/out_head_2_anchor_4、形状:b, 25, 43, 6- アクションの信頼度

説明:

b- バッチサイズnum_priors- SSD 形式の前の件数 (50x85x1+25x43x4=8550 に相当)

デモの使い方#

このモデルは、Open Model Zoo が提供する次のデモで使用して、その機能を示します:

法務上の注意書き#

* その他の社名、製品名などは、一般に各社の表示、商標または登録商標です。